https://github.com/myshell-ai/OpenVoice

GitHub - myshell-ai/OpenVoice: Instant voice cloning by MyShell.

Instant voice cloning by MyShell. Contribute to myshell-ai/OpenVoice development by creating an account on GitHub.

github.com

https://arxiv.org/pdf/2312.01479

오픈소스 TTS 모델 중 그나마 쓸만해보이는 모델 (보다는 프레임워크에 가까운..)

- Flexible Voice Style Control (emotion, accent, rhythm, pauses, )

- Zero-Shot Cross-Lingual Voice Cloning

가 특징이라고 합니다.

MSML(massive speaker multi lingual) training set + labeling 없이도 학습 가능하다는 장점이 있음

자신들이 open source TTS 중 SOTA 라고 주장

base speaker TTS model 사용

- v1 에서는 VITS 모델 사용 (영어, 중국어, 일본어 학습)

train the base speaker TTS model, we collected audio samples from two English speakers (American and British accents), one Chinese speaker and one Japanese speaker. There are 30K sentences in total, and the average sentence length is 7s. The English and Chinese data has emotion classification labels

- v2 에서는 자체적인 melo TTS 모델 사용 (다양한 언어 학습, robustness up)

=> base TTS model에서는 style parameters and languages 담당 (추출)

tone color extractor 가 아마 unique feature이지 않을까 싶음

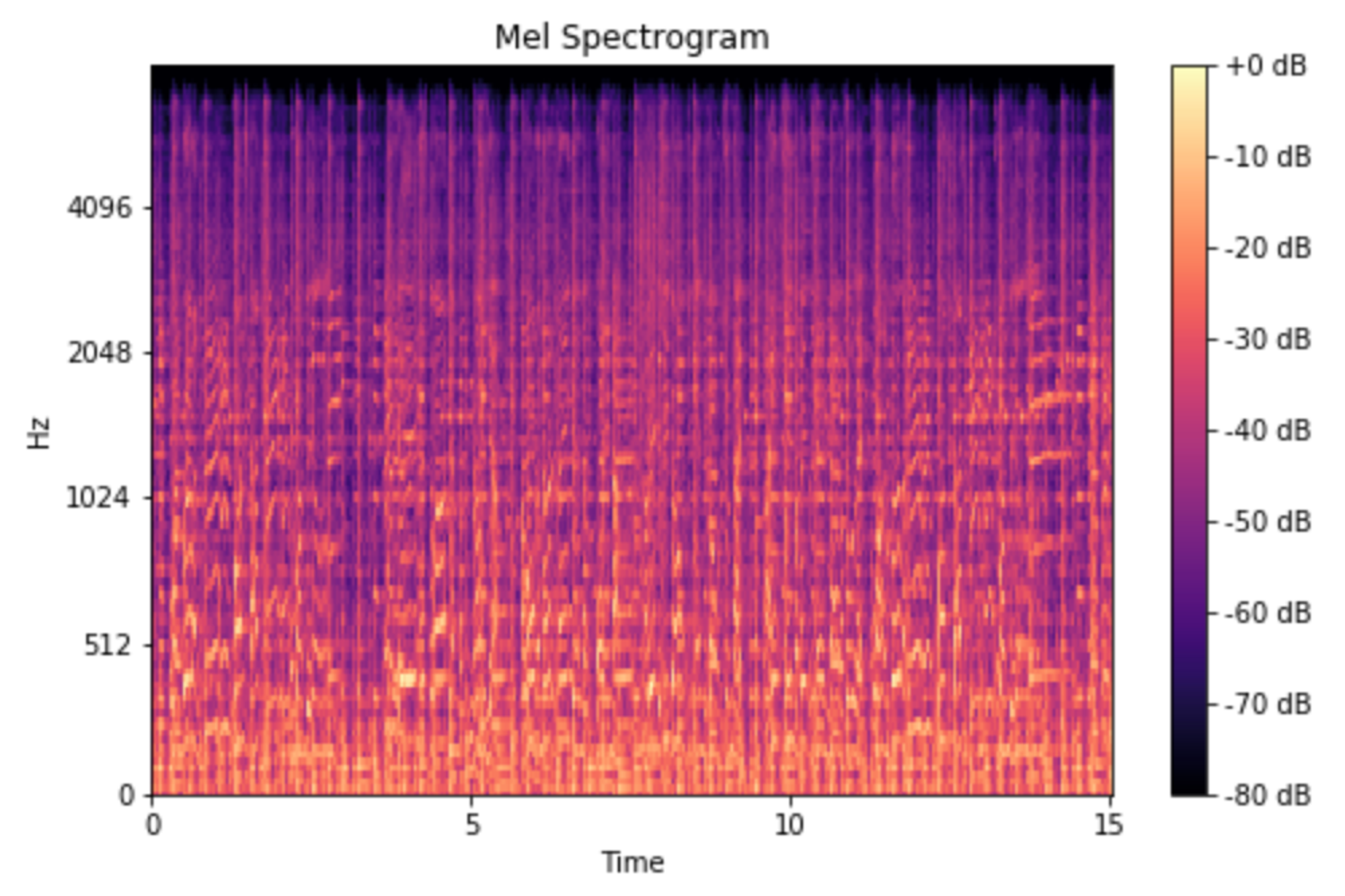

- simple 2D convolutional neural network that operates on the mel spectrogram on input voice

- cnn 거치면서 single feature vector 도출함

train the tone color converter, we collected 300K audio samples from 20K individuals. Around 180K samples are English, 60K samples are Chinese and 60K samples are Japanese.

mel spectogram?

동작 방식은 위 사진에도 나와있듯이

- TTS model에서 style param, language 등을 control

- encoder 거치면서 feature map output

- tone color information만 지우고 다른 style properties들은 보존

- reference file에서 추출한 tone color embodied to feature map

- decoded to raw waveforms

또 다른 유명 opensource tts 모델인 xtts-v2 가 2024년 1월을 끝으로 더 이상 유지보수 되지 않는다고 하니 (실제로 python 3.12에서 dependencies issue 존재)

openvoice v2의 base TTS 및 tone extractor를 fine tune 해보는 것도 좋을 듯

'speech' 카테고리의 다른 글

| openai whisper - STT model (0) | 2024.08.15 |

|---|